2019.03.30

2019.03.30

浏览量:

浏览量:

自然语言处理热点介绍![]()

先看一则NLP的热点新闻:

谷歌2018年11月开源了一个强大的NLP深度学习框架Lingvo,侧重于语言相关任务的序列模型,如机器翻译、语音识别和语音合成。过去两年来,谷歌已经发表了几十篇使用Lingvo获得SOTA结果的论文。

资料来源:新智元

https://mp.weixin.qq.com/s/QNk3vf8WWqSPNN-61W64zQ

一则新闻,涉及许多新概念,下面简单介绍一下。

一些概念

Natural Language Processing

自然语言处理

包括如下的内容范畴:

文本朗读(Text to speech)/语音合成(Speech synthesis)

语音识别(Speech recognition)

中文自动分词(Chinese word segmentation)

词性标注(Part-of-speech tagging)

句法分析(Parsing)

自然语言生成(Natural language generation)

文本分类(Text categorization)

信息检索(Information retrieval)

信息抽取(Information extraction)

文字校对(Text-proofing)

问答系统(Question answering)

机器翻译(Machine translation)

自动摘要(Automatic summarization)

文字蕴涵(Textual entailment)

自然语言处理的基本内容是让计算机像人一样完成对语言的处理。最基本的分词、情感分析等,上世纪60年代都开始研究,如今已非常成熟了,但涉及到语义、句法,就比较复杂,还在研究阶段,一千个读者有一千个哈姆雷特,何况要计算机能像人一样使用语言。

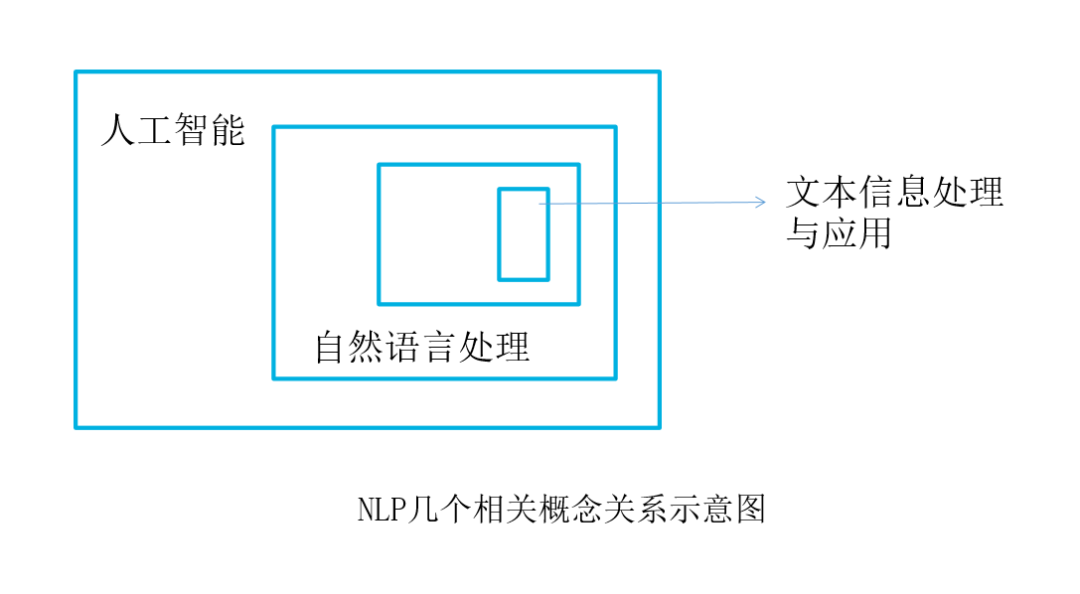

从知识范围上看,NLP属于人工智能的一个模块,文本信息处理又隶属于NLP的范畴。

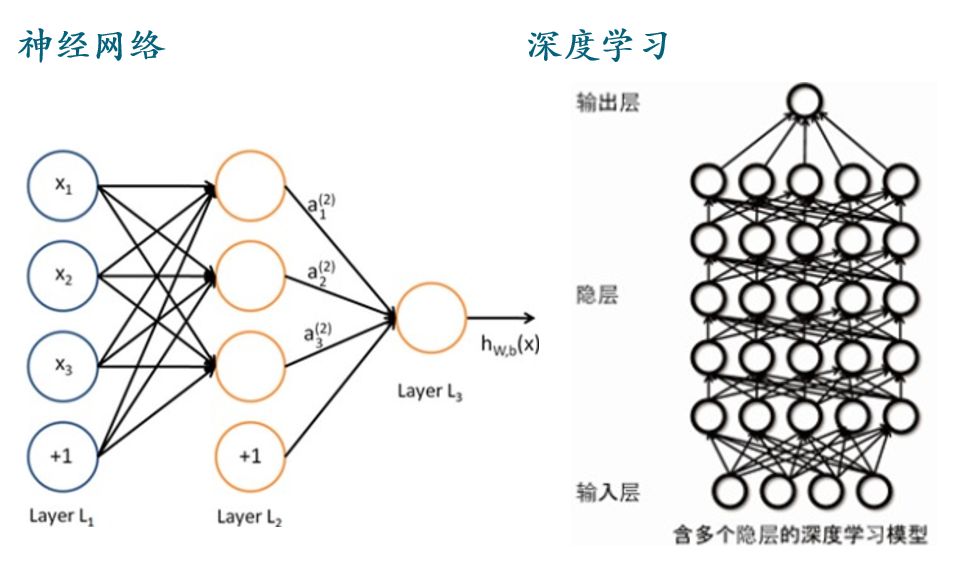

深度学习—Deep Learning

Lingvo 和TensorFlow

Lingvo是使用TensorFlow开发的一个通用深度学习框架,侧重于语言相关任务的序列模型,如机器翻译、语音识别和语音合成。

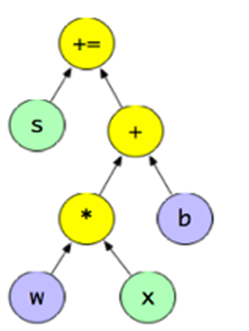

TensorFlow是一个采用计算图的形式表述数值计算的编程系统,本身是一个开源软件库。由Google大脑小组——隶属于Google机器智能研究机构——的研究员和工程师们所开发,用于机器学习和深度神经网络方面的研究。

NLP流程

计算机不能直接理解和处理人类的自然语言,怎么进行自然语言分析呢?

人们先将自然语言转分词,然后化成特征向量,再通过计算机处理。

分词

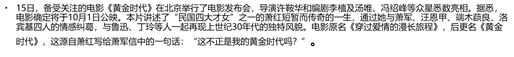

比如下面一段新闻:

分词之后,变成如下的文本:

特征向量

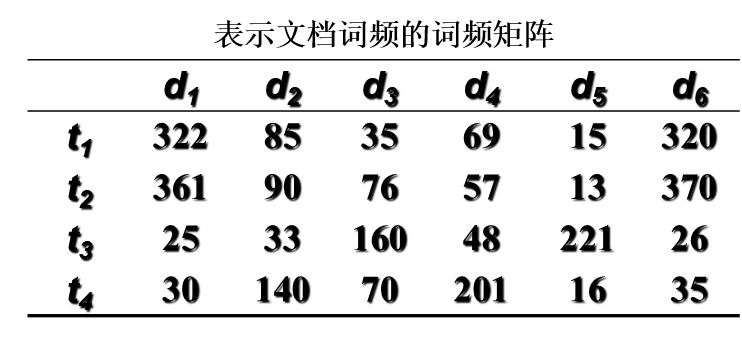

分词之后,统计每个词出现的频数,就是词频,一个文本可以获得其词语和频数的特征向量。

把许多文本进行上述处理之后,就可以获得文本的向量矩阵了。![]()

基于特征向量矩阵,进行数据降维之后,就可以实现熟悉的聚类、分类识别等等模型了。

但是可以看到,分词之后分析文本,损失了大量的信息,比如下面两句话:

A喜欢B

B喜欢A

含义当然不同,但分词之后,每个词语出现的频数是一样的。

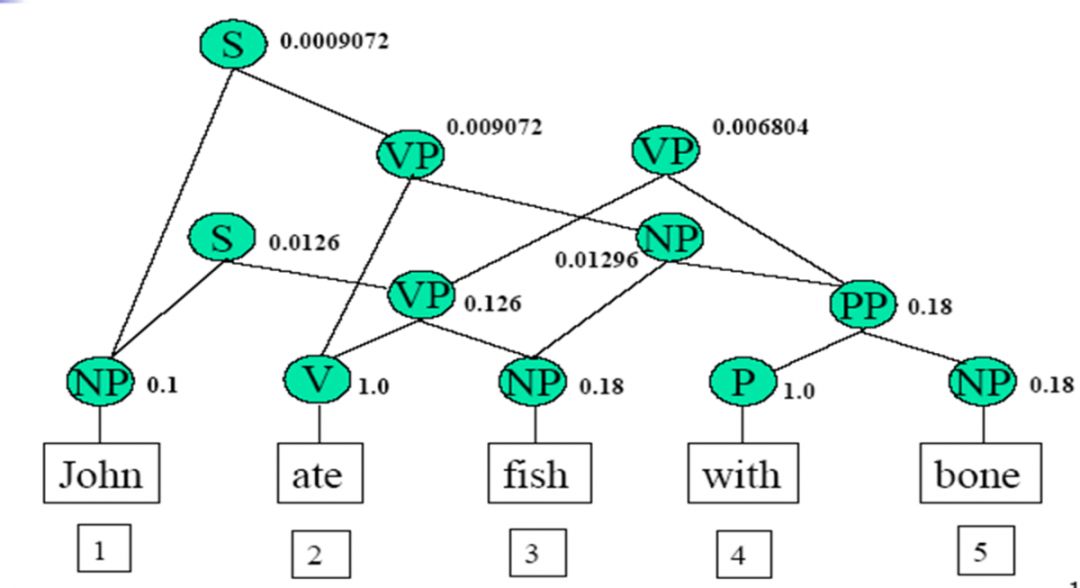

所以分词之上,还有句法和语义分析。比如根据设每个词在句子中的前后顺序,关联概率,训练学习模型,让机器识别和组织语句。这里的模型和方法就复杂了。目前NLP最精深的研究,都在这一领域。![]()

一些复杂的NLP模型

下面介绍一些复杂的NLP模型,这些模型大多是国外先进的计算机公司或大学开发,不断公开了代码,有兴趣的朋友可以很容易在网上找到资源,但是需要注意:代码庞大,参数惊人,训练一次代价不菲。

BERT

Bidirectional Encoder Representations from Transformers的缩写,是一种新型的语言模型,通过联合调节所有层中的双向Transformer来训练预训练深度双向表示。

MLM可以从文本执行双向学习,即允许模型从单词前后相邻的单词,学习每个单词的上下文,这是传统方法做不到的。

NSP使得BERT可以通过预测上下句之间是否连贯来得出句子之间的关系。给出50%正确上下句配对,并补充50%的随机上下句配对,然后对模型进行训练

资料来源:新智元

https://mp.weixin.qq.com/s/IecRICoC-BWqr7Tg_sVnQw

GPT-2

GPT-2 可以生成连贯的文本段落,刷新了 7 大数据集基准,并且能在未经预训练的情况下,完成阅读理解、问答、机器翻译等多项不同的语言建模任务。

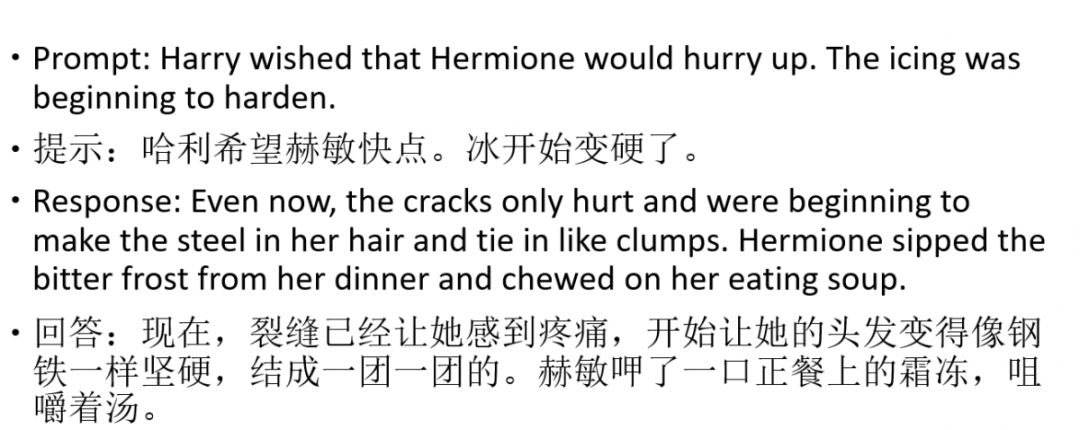

此模型下,给计算机一个提示,计算机可以自动生成许多对话,比如下例

资料来源:新智元

https://mp.weixin.qq.com/s/m18r8aA5QlreNGKan5G7IA

机器学习算法与Python学习

https://mp.weixin.qq.com/s/FydONubC0jTu4Cjb5kbiYA

虽然有些文不对题,不入文科专业之眼,但是计算机能够自动生成语句,回应之后,甚至生成剧本,实在是了不起的进步了。

一些研究成果

The Best of Both Worlds: Combining Recent Advances in Neural Machine Translation. Mia X. Chen, Orhan Firat, Ankur Bapna, Melvin Johnson, Wolfgang Macherey, George Foster, Llion Jones, Mike Schuster, Noam Shazeer, Niki Parmar, Ashish Vaswani, Jakob Uszkoreit, Lukasz Kaiser, Zhifeng Chen, Yonghui Wu, and Macduff Hughes. ACL 2018.

Revisiting Character-Based Neural Machine Translation with Capacity and Compression. Colin Cherry, George Foster, Ankur Bapna, Orhan Firat, and Wolfgang Macherey. EMNLP 2018.

Training Deeper Neural Machine Translation Models with Transparent Attention. Ankur Bapna, Mia X. Chen, Orhan Firat, Yuan Cao and Yonghui Wu. EMNLP 2018.

Google's Neural Machine Translation System: Bridging the Gap between Human and Machine Translation. Yonghui Wu, Mike Schuster, Zhifeng Chen, Quoc V. Le, Mohammad Norouzi, Wolfgang Macherey, Maxim Krikun, Yuan Cao, Qin Gao, Klaus Macherey, Jeff Klingner, Apurva Shah, Melvin Johnson, Xiaobing Liu, Łukasz Kaiser, Stephan Gouws, Yoshikiyo Kato, Taku Kudo, Hideto Kazawa, Keith Stevens, George Kurian, Nishant Patil, Wei Wang, Cliff Young, Jason Smith, Jason Riesa, Alex Rudnick, Oriol Vinyals, Greg Corrado, Macduff Hughes, and Jeffrey Dean. Technical Report, 2016.

资料来源:新智元

https://mp.weixin.qq.com/s/QNk3vf8WWqSPNN-61W64zQ

机器学习算法与自然语言处理

https://mp.weixin.qq.com/s/iAayDgnnHiPbXOE1v07Kdw

国内一些NLP平台

● 百度AI

●http://ai.baidu.com/tech/nlp?track=cp:ainsem|pf:pc|pp:chanpin-NLP|pu:NLP-ziranyuyanchuli|ci:|kw:10001503

● 中科院分析系统NLPIR

● http://ictclas.nlpir.org/nlpir/

● 玻森中文语义开放平台

●https://bosonnlp.com/demo?source=home-banner